AI MCP 简单理解

-

MCP(Model Context Protocol)是一种允许AI模型与外部工具和服务交互的开放标准协议。

-

MCP使AI能够访问外部资源、执行特定操作,从而增强AI的能力范围

-

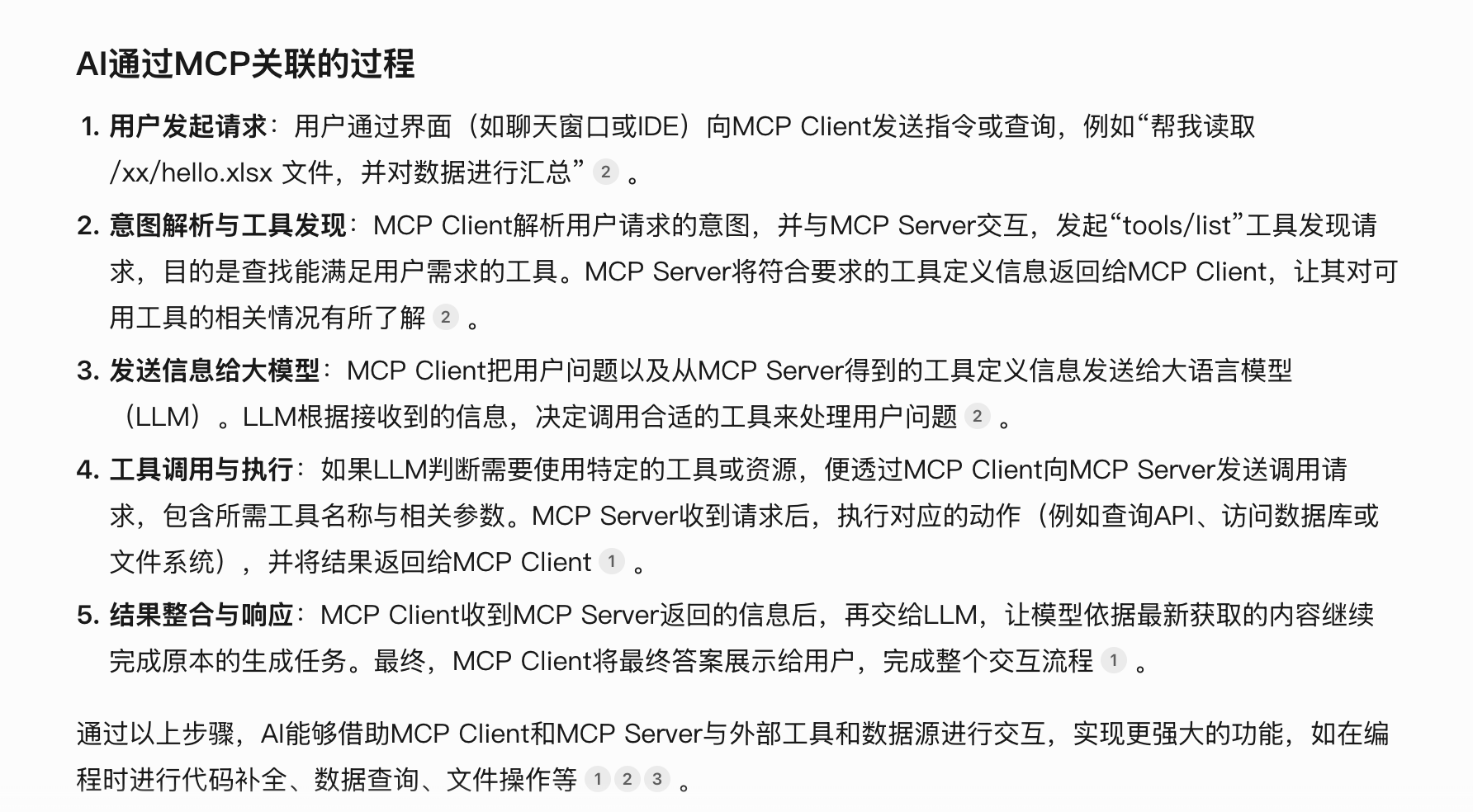

MCP 主机:这是集成了 MCP 功能的 AI 驱动应用程序。实际示例包括 Claude Desktop、Cursor、Windsurf、VS Code、DeepChat 等。这些应用程序通过实现 MCP 客户端来集成 MCP。

-

MCP 客户端:MCP 客户端是基础实现层,通常托管在功能丰富的 AI 应用程序、代理框架及其他类似应用中。它是与 MCP 服务器通信的接口。

-

MCP 服务器:MCP 服务器是提供“世界”功能的部分。例如,LLM 无法直接访问您的本地文件,对吧?但如果 MCP 服务器提供了文件访问工具,LLM 就可以列出、读取和操作这些文件。MCP 服务器实现了 LLM 现在可以访问的这些扩展功能、知识和操作。

![]()

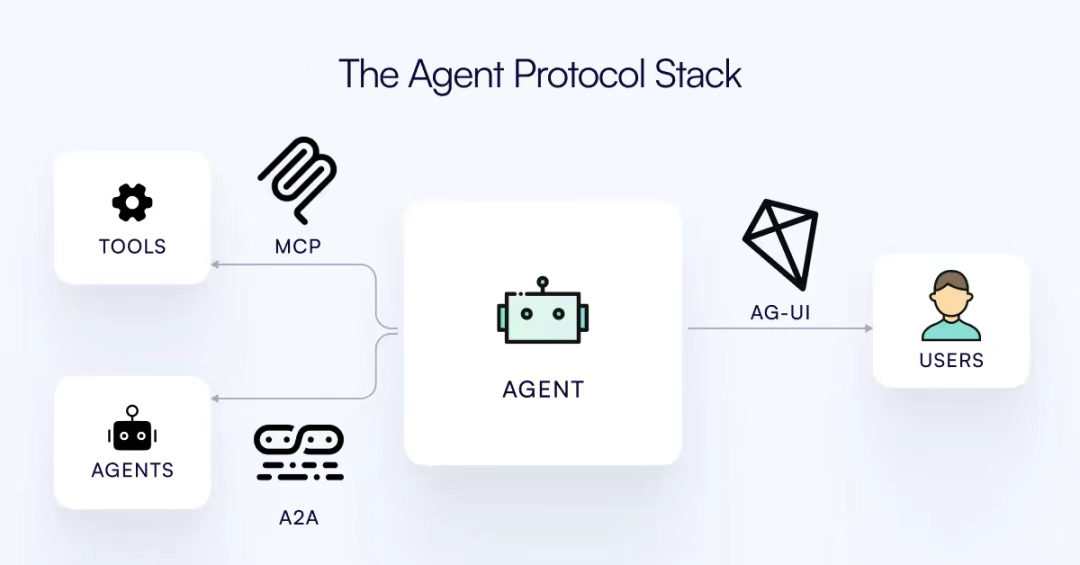

Agent框架的三个主流协议进行介绍,包括

MCP协议——解决AI Agent和外部工具交互问题;

A2A协议——解决Agent间通信问题;

AG-UI协议——解决AI Agent与前端应用之间的交互标准化问题。

https://mp.weixin.qq.com/s/WYQWJJ8w-29-j5FcQndGng

-

Tools(工具):允许LLMs通过服务器执行操作,能够调用外部服务和API代表AI模型执行操作。当Client请求操作时,MCP Server会识别合适的工具、与服务交互并返回结果。与传统函数调用不同,MCP的Tools通过标准化接口使模型能基于上下文自主选择并调用工具,这些工具遵循标准化的供给 - 消费模式,实现模块化、可复用性,并能被其他应用轻松接入,从而提升系统效率和灵活性。例如,通过Shodan MCP Server可执行网络威胁扫描,通过Playwright MCP Server能控制浏览器自动化。

-

Resources(资源):向LLMs暴露服务器中的数据和内容,提供对结构化和非结构化数据集的访问,这些数据可来自本地存储、数据库或云平台。当AI模型请求特定数据时,MCP Server会检索并处理相关信息,支持模型进行数据驱动的决策。比如,可配置MCP Server访问本地文件系统中的文件、数据库中的表等。

-

MCP Client则在其中起到连接和交互的关键作用,负责与MCP Server沟通,处理两端的消息传递与转换

协议转换:将LLM生成的指令(如“查询深圳天气”)转换为JSON - RPC 2.0格式的请求,以便与MCP Server进行通信。同时,将MCP Server返回的响应信息转换为LLM能够理解的格式。

通信枢纽:管理Host与Server之间的持久化连接,支持本地进程间通信(通过STDIO)与远程HTTP/2传输(通过SSE事件流)两种模式。例如,Cursor IDE中的Client在代码补全时,会同时连接本地的Git服务器和云端的文档检索服务。

安全代理:实现动态权限审批机制,当首次调用敏感操作(如文件读写)时触发用户确认弹窗。采用TLS加密保障数据传输安全,并通过沙箱技术隔离高风险操作,确保通信的安全性。

性能优化器:内置流量控制算法,根据服务器响应速度动态调整请求频率。实测在连接高负载服务器时,Client可将延迟降低约35%(Anthropic基准测试数据)。